今日值得关注的大模型前沿论文:

快手团队推出高效视觉语言模型 EVLM

苹果推出 LazyLLM:高效生成下一个 token

Stability AI 推出文生音频模型 Stable Audio Open

Google DeepMind:利用 JumpReLU 稀疏自动编码器提高重建保真度

微软:用“打破-修复”循环对齐 LLM

MIT 团队推出 FLUTE:查找表量化 LLM 的快速矩阵乘法

想要第一时间获取每日最新大模型热门论文?

请添加微信 Tobethenum1(一定要备注“姓名+职业+公司”,否则不予通过),

小助手会在 24 小时内邀请您加入「大模型技术分享群」。

ps:我们日常会分享日报、周报,后续每月也会出一期月报,敬请期待~

01

快手团队推出

高效视觉语言模型 EVLM

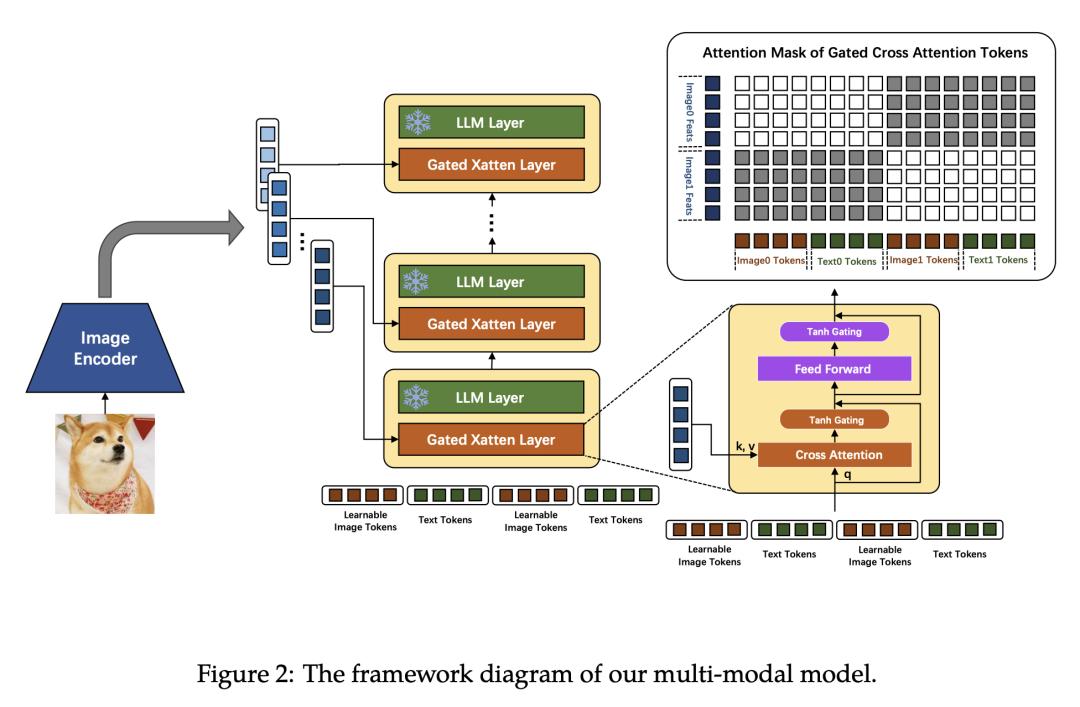

在多模态语言模型(MMLM)领域,大多数方法都建立在类似于 LLaVA 的架构上。这些模型使用单层 ViT 特征作为视觉 prompt,将其与文本 token 一起直接输入语言模型。但是,在处理长序列的视觉信号或视频等输入时,语言模型的自注意力机制会导致大量的计算开销。此外,使用单层 ViT 特征使得大语言模型(LLM)难以完全感知视觉信号。

为此,来自快手的研究团队提出了一种高效的多模态语言模型,以最大限度地降低计算成本,同时使模型尽可能全面地感知视觉信号。他们的方法主要包括:(1) 采用与 Flamingo 类似的交叉注意力图像-文本交互。(2) 利用分层 ViT 特征。(3) 引入混合专家(MoE)机制,以提高模型的有效性。

此模型在公开的多模态基准测试中取得了具有竞争力的成绩,并在图像字幕和视频字幕等任务中表现出色。

论文链接:

https://arxiv.org/abs/2407.14177

02

苹果推出 LazyLLM:

高效生成下一个 token

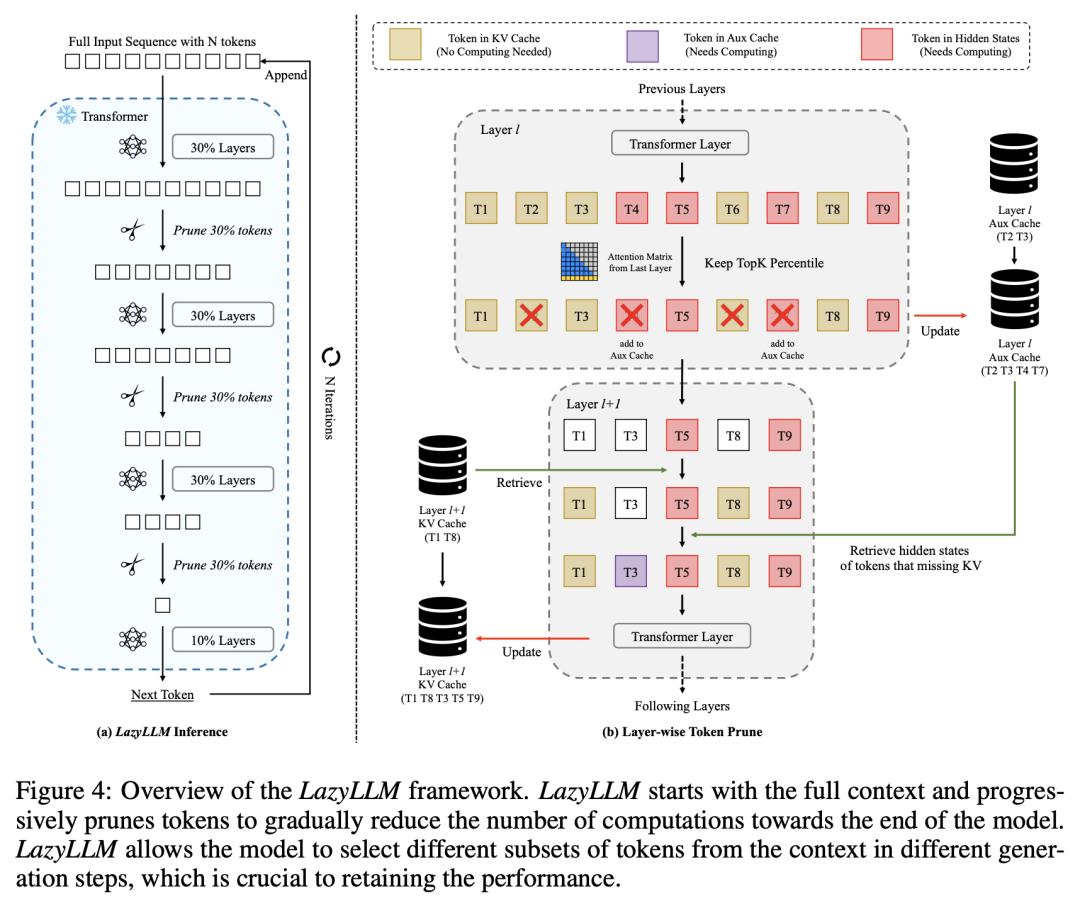

基于 transformer 的大语言模型(LLM)推理包括两个连续阶段:(1) 计算 prompt 的键值缓存并生成第一个 token 的预填充阶段,(2) 生成后续 token 的解码阶段。

对于长 prompts,必须在预填充阶段计算所有 token 的键值缓存,这会大大增加生成第一个 token 所需的时间。因此,预填充阶段可能会成为生成过程的瓶颈。问题是,是否所有 prompt token 都是生成第一个 token 所必需的。

为此,来自苹果公司的研究团队提出了一种名为 LazyLLM 的新方法。它可以在预填充和解码阶段选择性地计算对预测下一个 token 很重要的 token 键值。与一次性剪枝 prompt 的静态剪枝方法相反,LazyLLM 允许语言模型在不同的生成步骤中动态地从上下文中选择不同的 token 子集,即使这些 token 子集可能在之前的步骤中被剪枝过。

在各种任务的标准数据集上进行的大量实验表明, LazyLLM 是一种通用方法,可以与现有的语言模型无缝集成,在不进行微调的情况下显著加快生成速度。例如,在多文档问答任务中,LazyLLM 将 LLama 2 7B 模型的预填充阶段加快了 2.34 倍,同时保持了准确性。

论文链接:

https://arxiv.org/abs/2407.14057

03

Stability AI 推出

文生音频模型 Stable Audio Open

开放的生成模型对社区来说至关重要,它允许进行微调,并作为展示新模型的基准。然而,目前大多数文本转音频模型都是私有的,艺术家和研究人员无法在此基础上建立模型。

为此,Stability AI 公开了一个新的开放权重文本-音频模型的架构和训练过程,该模型是利用 Creative Commons 数据训练而成的。

评估结果表明,该模型在各种指标上的表现都能与最先进的模型相媲美。值得注意的是,所报告的 FDopenl3 结果(衡量各代产品的逼真度)展示了该模型在 44.1kHz 下进行高质量立体声合成的潜力。

论文链接:

https://arxiv.org/abs/2407.14358

GitHub 地址:

https://github.com/Stability-AI/stable-audio-tools

04

Google DeepMind:

利用 JumpReLU 稀疏自动编码器

提高重建保真度

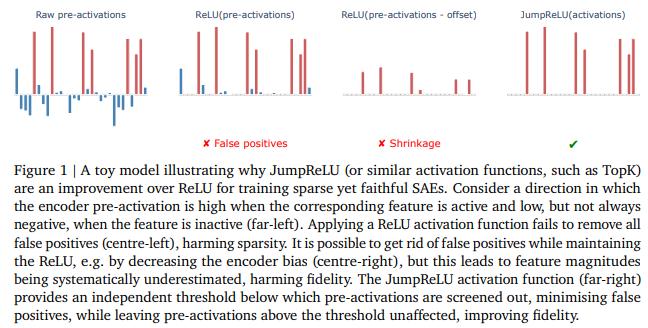

稀疏自动编码器(SAE)是一种很有前途的无监督方法,可用于识别语言模型(LM)激活中的因果相关和可解释的线性特征。为了在下游任务中发挥作用,SAE 需要忠实地分解 LM 激活;然而,为了具有可解释性,分解必须是稀疏的。这是两个相互矛盾的目标。

来自 Google DeepMind 的研究团队推出了 JumpReLU SAE,与 Gated 和 TopK SAE 等其他最新技术相比,JumpReLU SAE 在 Gemma 2 9B 激活的给定稀疏程度下实现了重构保真度 SOTA。研究团队还通过手动和自动可解释性研究表明,这种改进不会以牺牲可解释性为代价。

JumpReLU SAE 是对 vanilla (ReLU) SAE 的简单修改,研究团队用不连续的 JumpReLU 激活函数取代了 ReLU,而且训练和运行的效率也很高。通过有原则地利用直通估计器(STEs),他们展示了如何在 SAE 的前向传递中引入不连续 JumpReLU 函数的情况下,仍能有效地训练 JumpReLU SAE。同样,他们利用 STE 直接将 L0 训练成稀疏的,而不是在 L1 等上进行训练,从而避免了收缩等问题。

论文链接:

https://arxiv.org/abs/2407.14435

05

微软:

用“打破-修复”循环对齐 LLM

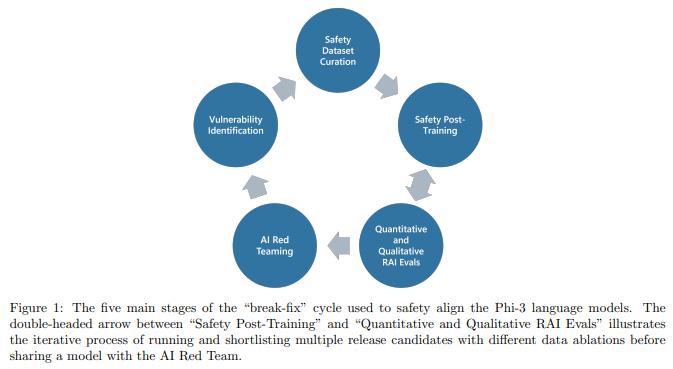

最近在语言模型训练方面的创新表明,有可能创建出体积小到足以在智能手机上运行的高性能模型。随着这些模型被部署到越来越多的领域,确保将它们与人类偏好和安全考虑对齐至关重要。

在这项工作中,来自微软的研究团队介绍了对 Phi-3 系列语言模型进行安全对齐的方法。他们利用“打破-修复”循环,进行了多轮数据集整理、安全后训练、基准测试、红队测试和漏洞识别,以涵盖单轮和多轮场景中的各种危害领域。

结果表明,在各种负责任的人工智能基准测试中,这种方法不断改进了 Phi-3 模型的性能。

论文链接:

https://arxiv.org/abs/2407.13833

06

MIT 团队推出 FLUTE:

查找表量化 LLM 的快速矩阵乘法

大语言模型(LLM)的部署通常受到内存带宽的限制,其中主要的瓶颈是将模型参数从 GPU 的全局内存传输到其寄存器的成本。如果与融合了去量化和矩阵运算的定制内核相结合,纯权重量化就能通过减少内存移动量来加快推理速度。

然而,为权重量化 LLM 开发高性能内核面临着巨大的挑战,尤其是当权重被压缩到非均匀分割位宽(如 3 位)并进行非均匀、查找表(LUT)量化时。

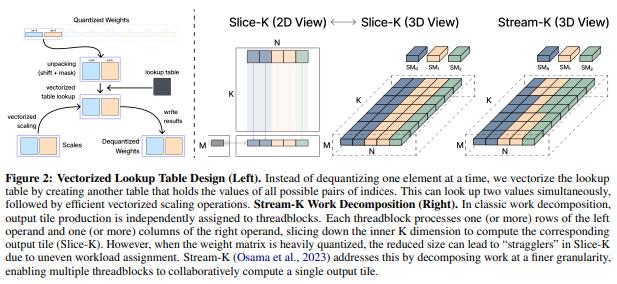

针对此挑战,来自麻省理工学院的研究团队及其合作者推出了用于 LUT 量化 LLM 的灵活查找表引擎 FLUTE,它采用离线重构量化权重矩阵的方式,最大限度地减少与解压缩相关的位操作,并对查找表进行矢量化(vectorization)和复制,以缓解共享内存带宽限制。

在批量小于 32 和量化组大小为 128(LLM 推理中的典型值)的情况下,FLUTE 内核的速度是现有 GEMM 内核的 2-4 倍。作为 FLUTE 的一项应用,研究团队探索了基于查找表的 NormalFloat 量化的简单扩展,并将其应用于各种配置的 LLaMA3 量化,从而获得了与强基线相比具有竞争力的量化性能,同时将端到端的吞吐量提高了 1.5-2 倍。

论文链接:

https://arxiv.org/abs/2407.10960

GitHub地址:

https://github.com/HanGuo97/flute

原标题:《苹果推出 LazyLLM:高效生成下一个 token;微软:用“打破-修复”循环对齐 LLM|大模型论文日报》